今週は人工知能にとって良い週でした。月曜日には、GoogleがTensorFlowを一般公開しました。これは、研究者が独自の人工知能プログラムを作成するために使用できる強力な機械学習プラットフォームです。火曜日には、NVIDIAがスーパーコンピュータ・オン・チップ「Jetson TX1」の大幅なアップデートを発表しました。そして今、MicrosoftはProject Oxfordと呼ばれる自社の人工知能ツールスイートをアップデートし、人間の感情を識別するプログラムや、騒がしい部屋の中で個々の人間の声を識別するプログラムなど、私たちがすぐに使うアプリに搭載される可能性のある強力な新機能を次々と追加しました。

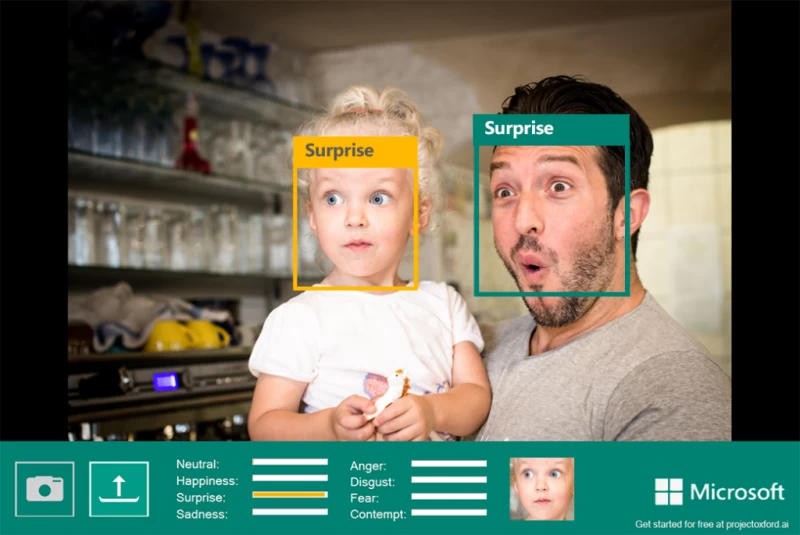

目玉となる新機能には、一連の新しいアプリケーション・プログラミング・インターフェース(API)が含まれます。これは、Microsoft以外のソフトウェア開発者が独自のアプリを開発するために使用できるツールです。Microsoftが特に宣伝したのは、機械学習を用いて表情から8つの感情状態(怒り、軽蔑、恐怖、嫌悪、幸福、平静、悲しみ、驚き)を認識するEmotion APIです。(これは、ポール・エクマンの作品によく似ており、より有名なテレビ番組「ライ・トゥ・ミー」が制作されました。)

Emotion API は本日から利用可能となり、今週初めに Movember 慈善団体の口ひげ識別 Web アプリケーション MyMoustache で初めて公開されました。

マイクロソフトは、これは店舗での製品に対する顧客の反応を測定する際や、反応型メッセージング アプリにも役立つ可能性があると述べている。

メッセージングといえば、マイクロソフトはスペルチェックAPIもリリースしています。これは、標準的なルールベースのチェッカーを改良したものです。このソフトウェアは、文中の「for」と「four」の違いを識別したり、ユーザーがよく使う表現(「selfie」など)を学習したりすることができます。マイクロソフトは、ユーザーのプライバシーに関して、これらのデータがどのように保存され、管理されるのかをまだ明確にしていません。

これは、Facebook の翻訳における機械学習に似ています。同社は、少なくとも毎月、Facebook の翻訳に組み込む新しいフレーズや俗語を探すためにユーザーの Facebook 投稿を収集しており、そのトレーニングの頻度を増やす作業を進めています。

コンピュータービジョンの分野では、Microsoftはカメラの揺れ、動き、顔を検出するビデオAPIもリリースします。このソフトウェアは、一部のアクションカメラのようにビデオを自動編集する機能に実装でき、Microsoft Hyperlapseにも使用されています。年末までにベータ版として公開される予定です。

マイクロソフトは、あらゆるニーズに対応するため、話している人の理解を容易にする2つのAPIも提案しています。1つは話者を識別するためのもので、もう1つは、混雑した部屋の騒音の中でも、あるいはアクセントのある人や話すのが難しい人の話でも、話の内容を認識するものです。ノイズを遮断するAPIは「カスタム認識インテリジェントサービス」と呼ばれ、年末に招待制で提供される予定です。

従来、AIシステムにとってアクセントや騒がしい環境を認識することは困難でしたが、研究者たちは今、その解決策を見つけています。例えば、Googleの音声検索の開発者は、AIがさまざまなフレーズを学習する際に聞くサンプルにノイズを追加することで、現実世界の環境により適合させています。

GoogleのTensorFlowプラットフォームは研究者やプログラマーを対象としていますが、Microsoftはアプリ開発者をターゲットに、焦点を絞った使いやすいAPIを提供しています。このような使いやすいツールがあれば、数十億ドル規模の企業に支えられていない、より一般的なアプリでも、ディープラーニングや人工知能(AI)をアプリに統合できるようになります。AIはソフトウェアの新たなフロンティアであり、Microsoftは小規模な開発者がAIに参入することをはるかに容易にしました。