人工知能(AI)は、私たちの仕事を機械に委ねることを可能にしました。機械は私たちの写真にタグを付け、車を運転し、ドローンを飛ばし始めています。これらのAIシステムは、最近のテスラのオートパイロットの事故や音声コマンドの聞き間違いのように、これらの作業を行う際に時折誤った判断を下すことがあります。しかし、新たな研究によると、AIに精通したハッカーは、これらのアルゴリズムに誤った、そして潜在的に有害な判断を強いる可能性があることが示唆されています。

研究者たちは、スマートフォンで撮影した写真において、AIアルゴリズムに最大97%の確率で誤認識させることで、これらの現実世界での攻撃を検証する第一歩を踏み出しました。実験では、紙に印刷された画像とスマートフォンで撮影された画像の変化は人間の目には見えませんが、実験室の外では、自動運転車が一時停止標識を認識しているか、何も認識していないかの違いが生じる可能性があります。

「100ドルの小切手に署名した人が、ATMで1000ドルと読み取られる状況を想像してみてください」と、OpenAIの研究者で論文の共著者であるイアン・グッドフェロー氏は述べている。グッドフェロー氏はまた、こうした攻撃は、機械学習アルゴリズムに画像をより魅力的だと思わせることで検索エンジン最適化(SEO)を向上させるために利用される可能性もあると指摘する。あるいは、金融機関が競合他社のAI株式トレーダーに誤った判断をさせるのにも利用できるとしている。

グッドフェロー氏は、この種の攻撃が実際に使用されたことは知らないが、人工知能の研究者は間違いなく検討を始めるべきものだと述べている。

AIを欺く研究は長年行われてきましたが、従来の研究では、一般的なカメラで撮影した実物の写真でこの種の攻撃が可能であることを証明できませんでした。イーロン・マスク氏が支援するOpenAIとGoogleが執筆したこの論文は、照明、視点、カメラの光学系、デジタル処理が変化しても、攻撃が成功する可能性を検証しています。

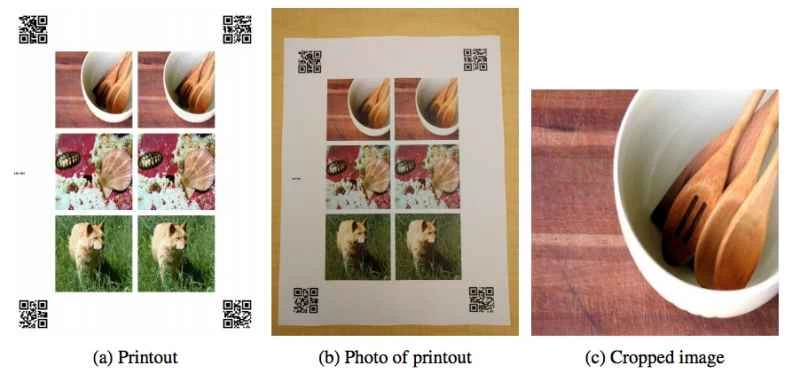

この脆弱性をテストするため、研究チームは、アルゴリズムに直接入力するとAIを欺くことが既に分かっている、わずかに改変した画像を、改変していない画像の隣に印刷した。そして、Nexus 5Xスマートフォンを使って、その紙の写真を撮影した。

研究者たちは印刷された画像を切り抜き、標準的な画像認識アルゴリズムにかけた。アルゴリズムは、何が写っているのかを識別できなかっただけでなく、97%の確率で上位5つの推測値のうち正しい結果を得ることさえできなかった。しかし、画像への変更の程度によって結果は低下した。一般的に、人間が認識しやすいような劇的な変更の場合、成功率は高かった。

彼らの目的は、AIが通常見るものを見えなくすることだけだった。ただし、過去の研究では、これらの改変された画像は特定の物体として認識されることがあった。研究者たちは使用したカメラの種類を考慮していないが、カメラの光学系を調整することで結果が改善されることを期待している。

他の研究では、音声を使った同じ手法を使用して、Android スマートフォンを騙して Web サイトにアクセスさせ、悪意のある音声コマンドで設定を変更させています。

ジョージタウン大学とカリフォルニア大学バークレー校を拠点とするこの研究グループは、「OK Google」などの録音された音声コマンドを改変し、人間がほとんど理解できないように歪めることができる。

「隠された音声コマンドは、イベントのスピーカーから放送されたり、YouTubeのトレンド動画に埋め込まれたりして、単一の攻撃の範囲を拡大する可能性がある」と研究者らは、8月に開催されるUSENIXセキュリティシンポジウムで発表されるジョージタウン大学とバークレー大学の論文に記している。

このような公開攻撃により、スマートフォンやコンピューター(新たに仮想パーソナルアシスタントを搭載したもの)が悪意のある Web サイトを表示したり、ユーザーの位置情報を Twitter に投稿したりする可能性があります。

これらの攻撃は、写真のラベルが誤って付けられる程度で、AI の一部の用途では無害かもしれませんが、ロボット工学、航空電子工学、自律走行車、さらにはサイバーセキュリティにおいては、その影響は現実のものです。