MITの学生たちは、独り言を言っているときに口に出した言葉を認識し、言っていると解釈した内容に基づいて行動を起こすことができる「AlterEgo」というプロトタイプのデバイスを作成した。

MITメディアラボ(マサチューセッツ工科大学(MIT)傘下の、人間とテクノロジーの交差点を研究する部門)の修士課程学生で、論文の著者でもあるアーナフ・カプール氏は、このデバイスが思考や、たまたま頭に浮かんだランダムな言葉を読み取るわけではないことを強調する。「あなたは完全に沈黙していますが、独り言を言っています」と彼は言う。「考えているわけでも話しているわけでもありません。それは自発的でありながらプライベートでもある、その中間の絶妙なバランスです。私たちはそれを捉えているのです。」

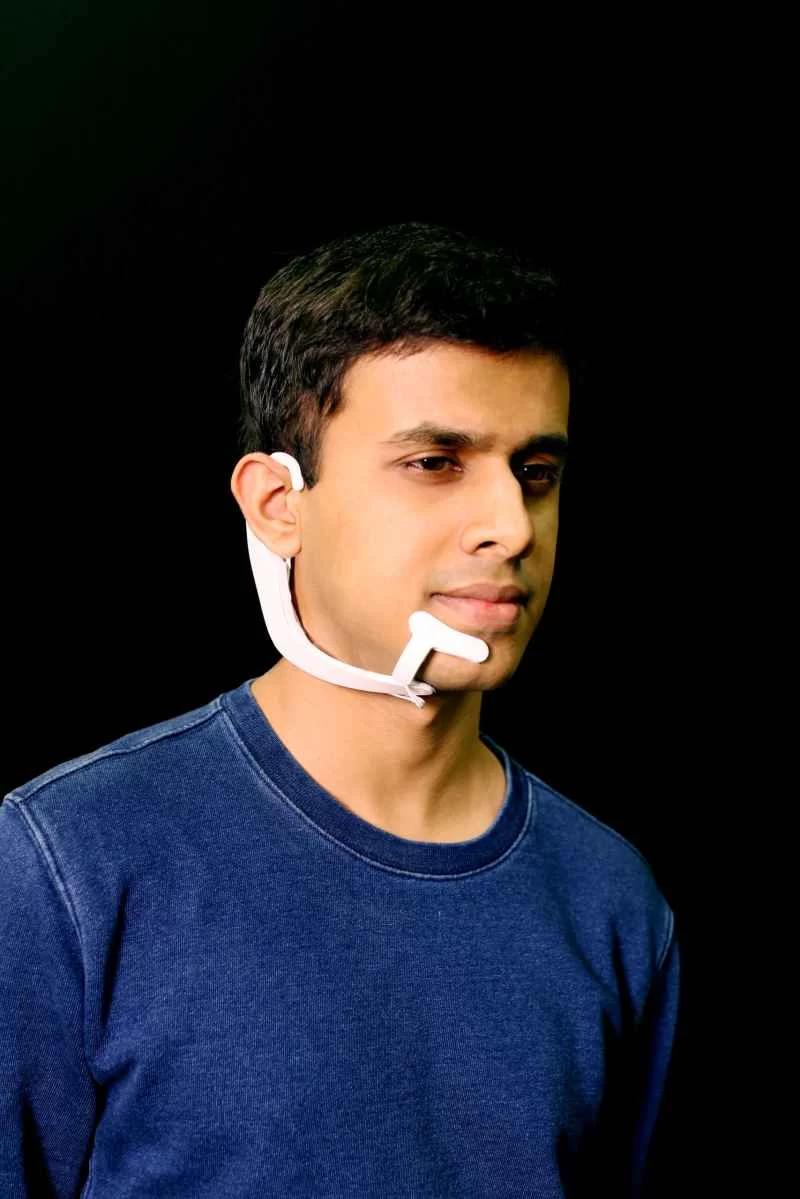

現時点のプロトタイプシステムは、テレマーケティング担当者が装着するような白いヘッドセットに似ています。しかし、唇の前にマイクが浮かんでいるのではなく、顔と首に貼り付けられ、そこに設置された複数の電極が、静かに独り言を言う際に生じる微妙な内部筋の動きから発生する微弱な電気信号を拾います。デバイスはBluetooth経由でコンピューターに接続し、サーバーと通信して信号を解釈し、装着者が発している言葉を判別します。

まだプロトタイプ段階ですが、従来の常識から大きく逸脱した興味深い技術です。私たちはデバイスとのやり取りを、ほとんどの場合、タッチで行います。スマートフォンで文字を入力したり、アプリをタップしたり、AppleのAirPodsの側面をダブルタップして音楽を一時停止したり再生したりします。あるいは、Siri、Alexa、Googleアシスタントといったデジタルアシスタントを使って、ガジェットやスマートスピーカーに話しかけます。これらのサービスは、ただ静かに独り言を言う以上のことを要求します。言い換えれば、この種の技術は、簡易版のSiriにあなたのささやきを聞いてもらうようなものです。

これらすべての目標は? カプール氏は「人間とコンピューターの融合」をさらに深めることだと語る。コンピューターとのインタラクションが密になればなるほど、作業から目を離してクリック、タップ、あるいは入力することなく、数学の問題や翻訳のヘルプを素早く得るなど、コンピューターの強みを活用できるようになる。

あるいは、Rokuのリモコンは小さくて紛失しやすいので、チャンネルを変えるだけでも全く音を立てずに済むかもしれません。AlterEgoは、障害のある人や麻痺のある人にも有望なようです。しかし、カプール氏によると、その用途についてはまだ研究できていないとのことです。

確かに、この技術はまだ初期段階にあるため、各アプリが学習できる単語数は約20種類にとどまっています。システムは人が話すすべての単語を理解できるわけではなく、学習済みの単語しか理解できません。カプール氏によると、意図的に独り言を言いながら、声に出して何も言わないのは、習得しやすい練習方法だそうです。この技術を人に使ってもらうためのトレーニングでは、まず文章を声に出して読んでもらうことから始めます。「その後、読んでいる間は単語を声に出さないようにお願いしています」とカプール氏は言います。「声に出して話すよりも楽なのです。」

このシステムを構築するにあたり、カプール氏はニューラルネットワークと呼ばれる一般的な人工知能ツールを使用しました。これはデータ入力から学習できるツールです。彼らはニューラルネットワークを訓練し、人が発する様々な言葉と、それに対応する様々な電気信号を認識できるようにしました。

こうしたデバイスの軍事利用は容易に想像できるが、ジョージア工科大学コンピューティング学部の教授、サド・スターナー氏はMITのウェブサイト上の声明で、こうしたデバイスを使った「特殊作戦」を思い描くことができると述べた。しかしカプール氏は、それがシステムの本来の目的ではないと述べている。

「これは、コンピューターと人間の間の溝をいかに埋めるかという問題です」と彼は言う。理想的なシナリオは、人々が人工知能システムの知性をスムーズかつリアルタイムに活用して、自らを拡張できるというものだ。

次のステップは、デバイスの形状を改良し、より「目立たないように」することです。重要なのはシームレスな統合です。理想的には、将来のバージョンは、テープで貼り付けたテレマーケティング用のヘッドセットのように見えなくなります。