Facebookの開発者会議「F8」で明らかになったことが一つあるとすれば、それはライブビデオがプラットフォームの将来にとって極めて重要であるということです。Facebookユーザーは誰でもスマートフォンから世界中に向けて配信できるようになっただけでなく、近い将来には他のカメラでも高品質な配信が可能になるでしょう。さらにFacebookは、世界最大のソーシャルネットワークで配信するインセンティブとして、ライブビデオを収益化することに注力しています。

しかし、ライブ動画はFacebookが動画に関して既に抱えている問題を悪化させています。ユーザーが何かを見たいと思っても、たいていは見つけられないのです。私たちが視聴する動画のほとんどは、友達やフォローしているページによって共有されているのです。

ここで人工知能(AI)の出番です。将来的には、AIが世界中で配信されるすべてのライブ動画を視聴し、何が起こっているかを理解し、検索可能にするだろうと、Facebookの応用機械学習責任者であるホアキン・キニョネロ・カンデラ氏は本日、 Popular Science誌とのインタビューで述べました。さらに、Facebookはこれらのストリームをまとめて、ユーザーが見たいコンテンツだけを配信するパーソナライズされたチャンネルを作成できるようになるかもしれません。

「この流れが軌道に乗れば、人々がキュレーションできる素晴らしいツールを作らなければならないでしょう」とキャンデラ氏は語った。「引退したスノーボーダーが何百万ものライブ配信をスキャンできるツールを持っていたら、プロが撮影した配信と、山にいる人たちの様子などを組み合わせられるでしょうか?もしそれを編集してミックスできたら、自分だけのテレビ局が作れるでしょう。これを実現したいなら、こうしたツールを開発する必要があるのです。」

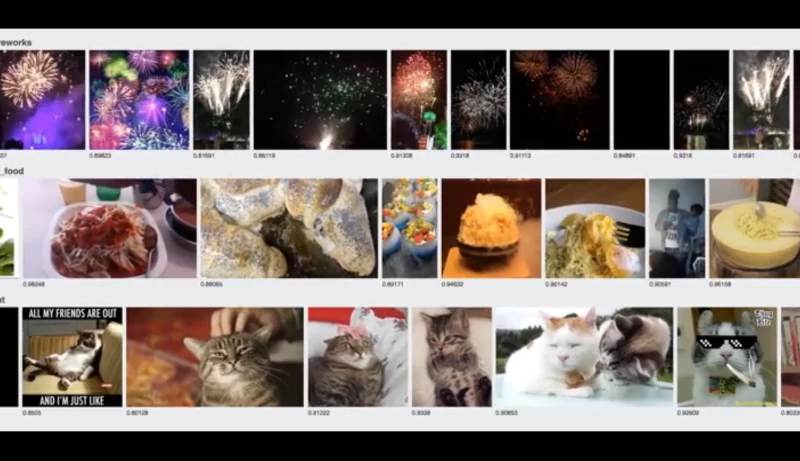

しかし、そこに到達するのは容易ではありません。現在、Facebookは画像内の物体を識別する方法の開発に取り組んでおり、動画への対応も始まったばかりです。

主な課題は、セマンティックセグメンテーションと呼ばれるものです。画像や動画に何が写っているかを理解する人工知能には、3つの段階があります。まず分類です。写真にはカップがあります。次にセグメンテーション(内容に基づいて画像を分割する)です。写真にはカップとテーブルがあります。最後のセマンティックセグメンテーションは最も難しく、キャンデラ氏によると、最も多くの作業が必要だそうです。カップはテーブルの上にあるということです。

AIがカップがテーブルの上に置かれることを理解するには、人間が世界を観察することで自然に理解できる、二つの物体の関係を理解する必要があります。ほとんどのシステムにとって、これは理解が困難です。なぜなら、二つの物体が別々であることを認識すると同時に、その関係性を共有するには、膨大な量の事例が必要だからです。カップはテーブルの上に置かれますが、テーブルがカップの上に置かれることは滅多にありません。

動画は非常に高速に再生される画像の連続であるため、ライブ動画はもちろんのこと、あらゆる動画内の物体をAIが識別して理解するのは至難の業です。キャンデラ氏の夢は、現在導入されているシステムに基づくと実現には程遠いものですが、彼のチームは着実に前進しています。本日のF8基調講演で、キャンデラ氏はFacebookが顔認識のための動画処理に取り組んでいることを発表しました。この技術により、AIは動画に人物がいつ登場し、いつ登場し、どのくらいの時間滞在したかを判別できるようになります。この技術は、Facebookが長年にわたり高い精度で活用してきたAIベースの自動タグ付け機能を基盤としています。

しかし、ライブ動画の分析はFacebookの人工知能の強みを活かす大きなチャンスにもなり得るとキャンデラ氏は指摘する。人工知能の大きなセールスポイントは、動作しながら学習していく点にある。世界中から様々なトピックの動画がほぼ無制限に配信される環境は、新しいことを学ぶ絶好の機会となるのだ。