友達と一緒にソファを持ち上げていると想像してみてください。二人は反対側にいて、いつ持ち上げるか意思疎通が必要です。3つ数えて持ち上げてもいいですし、もしお互いの気持ちが通じ合っているなら、うなずくだけでもいいでしょう。

では、ロボットで同じことをするとしたら、ロボットに何をいつ行うべきかを指示する最適な方法は何でしょうか?MITのロボット工学者たちは、人間が物を持ち上げるのを助ける機械システムを開発しました。このシステムは、人間の上腕二頭筋から発せられる電気信号を直接読み取ることで機能します。

これは注目すべきアプローチです。なぜなら、彼らの方法は、ほとんどの人がテクノロジーと接する標準的な方法ではないからです。私たちは、AlexaやSiriなどのアシスタントに話しかけたり、スマートフォンをタップしたり、キーボード、マウス、トラックパッドを使ったりすることに慣れています。また、カメラ付きスマートホームタブレットのGoogle Nest Hub Maxは、ユーザーが動画を一時停止するなど、何かをしたい時に行う「停止」を示すハンドジェスチャーを認識できます。一方、ロボットカー(自律走行車)は、レーザー、カメラ、レーダーユニットなどの機器を使って周囲の状況を認識します。

しかし、これらのロボットシステムはどれも、このロボットのように人の筋肉の屈曲を計測していません。また、人が物を持ち上げている状況では、ロボットが音声コマンドを聞いたりカメラを使ったりするのは、いつ、どのくらいの高さまで持ち上げるべきかを判断するのに最適な方法ではないかもしれません。

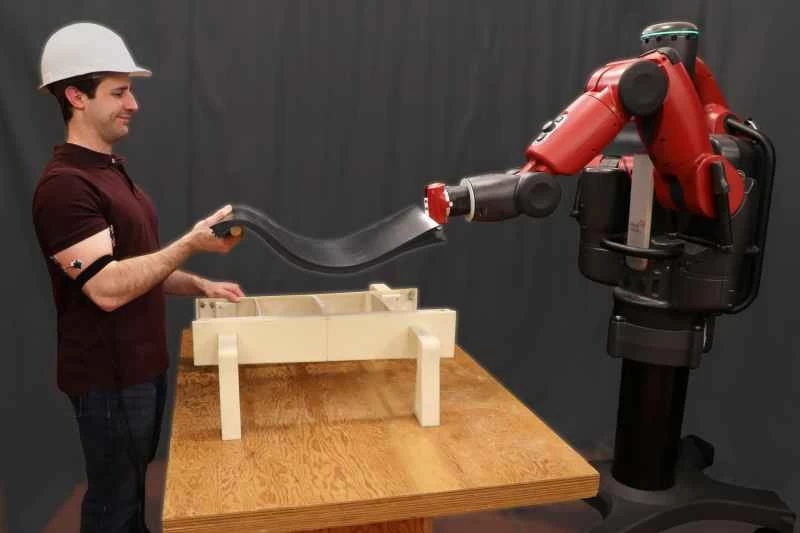

上腕二頭筋を感知するロボットは、文字通り人の上腕に貼り付けられ、ワイヤーでロボットに接続された電極によって動作します。「このシステムは全体として、人とロボットが物理的なタスクにおいてチームとして協力しやすくすることを目指しています」と、MITで人間とロボットのインタラクションを研究し、このシステムに関する論文の筆頭著者でもあるジョセフ・デルプレト氏は述べています。円滑な連携には良好なコミュニケーションが不可欠であり、このロボットの場合、そのコミュニケーションは直接人の筋肉から生まれます。「ロボットと一緒に何かを持ち上げているとき、ロボットはあなたの筋肉の活動を見て、どのように動いているかを把握し、それに基づいて支援を試みます。」

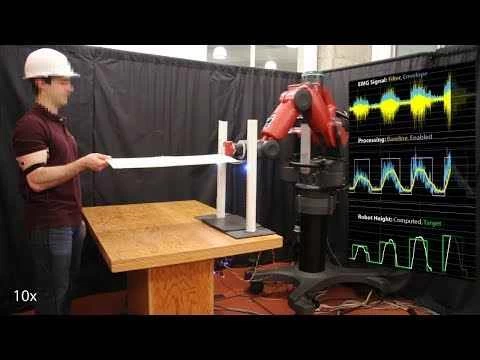

ロボットは、あなたの筋肉からの信号に2つの基本的な方法で反応します。最も単純な方法では、ロボットはあなたが腕を上下に動かす際に上腕二頭筋から発せられるEMG信号と呼ばれる信号を感知し、あなたの動きを真似します。また、実際に腕を動かさずに上腕二頭筋を曲げる(筋肉を緊張させたり弛緩させたり)ことで、ロボットハンドに上下に動かすよう指示することもできます。

このシステムは、人工知能(AI)の活用により、より微細な動きも解釈できる。ロボットアームに細かく上下運動を指示するには、上腕に電極を装着した人が手首を軽く2回上下に動かすだけで、ロボットアームが指示通りに動く。これを実現するために、デルプレト氏はデータから学習するAIシステム、ニューラルネットワークを採用した。ニューラルネットワークは人間の上腕二頭筋と上腕三頭筋から発せられる筋電図(EMG)信号を解釈し、1秒間に約80回分析して、ロボットアームに指示を出す。

このようなシステムが肉体労働を担うあらゆる人々にとってどれほど役立つかは容易に想像がつく。この研究はボーイング社の資金提供も一部受けている。「工場や建設現場で、チームを組んで大型または重い物を持ち上げる場面で活用できると考えています」とデルプレト氏は語る。もちろん、工場ではすでにロボットが一般的に導入されている。例えば、ミシガン州にあるゼネラルモーターズの鋳造工場では、エンジンブロックの鋳型を高温のアルミニウムが流れ込む場所まで持ち上げるといった、重労働や危険を伴う作業、あるいはその両方をロボットシステムが支援している。これは人間にはできない、そして人間が行うべきではない作業だ。

しかし、MITのシステムは、人間と機械が一緒に物を持ち上げるといった作業において、より直接的で、おそらくより直感的なつながりを可能にするだろう。結局のところ、人間とロボットはそれぞれ異なる種類の作業に優れている。「人間とロボットが密接に協力すればするほど、その相乗効果はより効果的になります」とデルプレト氏は言う。